Retrocedamos a 1949. Un joven matemático llamado John Nash busca una idea original para su tesis en la Universidad de Princeton. La teoría de juegos ya existía gracias a los trabajos previos (1944) de John von Neumann y Oskar Morgenstern, pero el modelo de von Neumann se centraba en juegos de suma cero (un jugador gana, el otro pierde).

Nash tuvo un chispazo de genialidad al proponer que en cualquier juego debería existir al menos un punto en el que ningún jugador podía mejorar su situación cambiando su estrategia de manera unilateral.

Formalizó aquella idea en un breve artículo de dos páginas ('Equilibrium Points in n-Person Games') en enero de 1950, y con ello revolucionó la historia. Incluida la de las impresoras.

¿Es la impresora el peor producto tecnológico de la historia?

Y es que el de las impresoras es un ejemplo casi de manual para aplicar el llamado equilibrio de Nash. Este tipo de productos llevan décadas siguiendo —al menos, en gran medida— el modelo económico de la maquinilla y las cuchillas: vendes barato la primera, pero cara la segunda.

Los consumidores sabemos que cuando compramos una impresora de tinta, el precio va a ser económico, casi ridículo. Pero también tenemos asumido que la tinta y los cartuchos para esas impresoras van a ser carísimos. Y si no lo son, lo que lo acabará siendo es la suscripción a la tinta... o a las propias impresoras.

No solo eso: en los últimos 30-40 años hemos visto cómo las impresoras se han convertido en —probablemente— el peor producto tecnológico de la historia. No es ya solo que las impresoras se puedan atascar o funcionen de forma errática.

El verdadero problema es la terrorífica forma en la que los fabricantes han protegido su negocio, impidiendo de todas las formas posibles que los usuarios puedan por ejemplo utilizar cartuchos y tóneres compatibles de terceros.

El equilibrio de Nash explica muy bien por qué los fabricantes hacen lo que hacen. Imaginemos a dos grandes fabricantes como HP y Canon con dos opciones:

- Cartuchos caros y bloqueados (modelo actual)

- Cartuchos baratos y abiertos (que permiten competencia y bajar precios)

Ante esa situación, los directivos de HP y Canon saben que pueden encontrarse tres tipos de situaciones de mercado:

- Si ambos mantienen cartuchos caros y bloqueados: ganan mucho

- Si uno "abre" sus cartuchos y baja precios y el otro se mantiene cerrado: el que abre pierde ingresos y el que sigue cerrado gana más... o lo contrario. Pase lo que pase, uno va a acabar ganando mucho y el otro perdiendo mucho.

- Si ambos abren: vuelve a haber competencia fuerte, pero ambos ganan menos

Ante ese escenario los fabricantes toman una decisión empresarial inevitable: cierran su tecnología de cartuchos y la venden cara porque eso es lo que les da más beneficios a todos.

El equilibrio de Nash se cumple aquí de forma implacable: describe un punto estable para cada jugador (empresa) pero no asegura que el resultado sea el mejor para el conjunto. Colectivamente y desde el punto de vista social lo óptimo sería abrir la tecnología y bajar los precios: las empresas ganarían menos, pero el mercado sería más grande y justo.

La realidad, como sabemos, es muy distinta. Pero quizás esa realidad pueda cambiar.

Necesitamos una "impresora Tesla"

El usuario de impresoras lleva por tanto 30 años sometido a una sangría constante que se traduce en un gasto exagerado en cartuchos y también en una erosión del tiempo y la productividad. Lo que ha pasado con las impresoras es algo extraordinario: hemos normalizado que las impresoras sean casi más un problema que una solución.

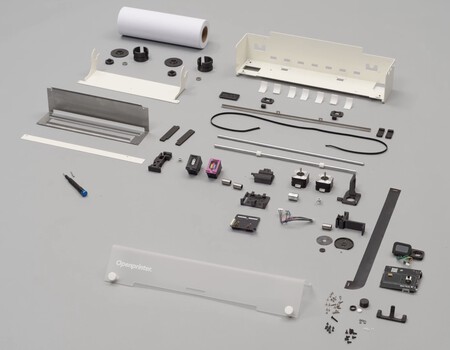

The Open Printer, un llamativo proyecto de impresora "Open Source" y que se basa en el uso de cartuchos de HP pero que acepta cartuchos compatibles de terceros. Fuente: The Open Printer.

Y precisamente por eso tenemos un panorama en el que existe una gran oportunidad para una revolución en el mercado de las impresoras. Este segmento está hambriento por un disruptor ético: el fabricante que abandone el equilibrio de Nash actual puede cambiarlo todo aquí.

Es un campo maduro en el que un innovador basado en la transparencia y la fiabilidad podría no solo capturar el mercado, sino incluso redefinirlo. Lo que necesita el mercado es una especie de "impresora Tesla".

Y nos referimos a una impresora que provoque en este segmento lo que Tesla logró provocar en la industria automovilística: una máquina que tenga un gran diseño, un funcionamiento fiable y que esté además pensada para durar. Pero sobre todo, que ofrezca una alternativa a las impresoras actuales y su filosofía dictatorial con los cartuchos.

Aquí hay ya algunos proyectos en marcha. El proyecto The Open Printer, de la startup parisina Open Tooks, está pensada como una impresora de tinta reparable, Open Source, y que centra su funcionamiento en cartuchos reparables. Sus creadores afirman que esta impresora está creada "con componentes mecánicos estándar y con partes modulares", lo que simplifica teóricamente su ensamblaje, modificación y reparación.

Fuente: The Open Printer.

De hecho la Open Printer funciona con una pequeña placa Raspberry Pi W como centro de operaciones. No hay firmware propietario ni cartuchos con DRM. Está pensada para usar cartuchos HP63 (HP 302 en Europa) tanto en negro y en color pero sirven tanto los de HP como los de terceros. Y no solo puede imprimir en folios AAr o A4, sino incluso en rollos de papel de 27 mm.

No hay de momento detalles sobre su precio o disponibilidad, pero la idea no se lanzará en tiendas directamente, y primero se lanzará como un proyecto de financiación colectiva. Sabemos por fracasos (y fraudes) anteriores que ese tipo de modelos de financiación tiene sus riesgos, pero en este caso esa opción parece razonable y solo queda esperar lo mejor del proyecto.

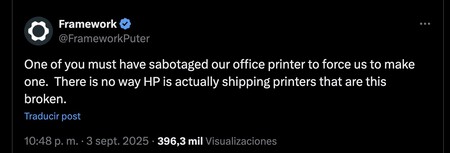

Puede que ese no sea el único lanzamiento en este sentido, y de hecho hay un rumor aún más interesante. Framework, la empresa que nos ha conquistado con sus portátiles reparables, parece estar considerando la idea de crear su propia impresora (¿modular y reparable? ¡Eso esperamos!).

Así al menos lo indica un mensaje reciente en X en el que comentaban cómo "Uno de vosotros debe haber saboteado la impresora de la oficina y nos ha forzado a fabricar una. No es posible que HP esté vendiendo impresoras así de rotas".

No hay más detalles, pero el hecho de que una empresa como Framework haya hecho esos comentarios nos hace pensar que efectivamente una impresora modular y reparable es posible. De hecho, si hay una empresa que puede hacer esa "impresora Tesla" con la que darle la vuelta al mercado esa es, precisamente, Framework.

Esa modularidad y reparabilidad haría posible algo impensable en las impresoras actuales. Podríamos así soñar con una impresora a la que poder reemplazar el cabezal de impresión, los rodillos o incluso la placa lógica. Eso eliminaría (o mitigaría) la obsolescencia programada y esa práctica habitual de "tirar la vieja para comprar la nueva" cuando una pieza menor falla.

De ser así, el equilibrio de Nash se rompería y HP y el resto de fabricantes tendrían probablemente que modificar su estrategia actual. El incentivo para desviarse del statu quo aparecería por primera vez en décadas en este segmento.

Probablemente veríamos campañas de desprestigio de esa impresora Open Source, pero quizás esos fabricantes tendrían que cambiar su modelo creando incluso sus propias impresoras modulares, reparables y de "tinta abierta", aunque probablemente con limitaciones para mantener algún tipo de control sobre la cadena de suministro y la experiencia de usuario.

Ahora solo queda esperar. Con un poco de suerte, el equilibrio de Nash tendrá que adaptarse a un nuevo jugador y a una nueva realidad.

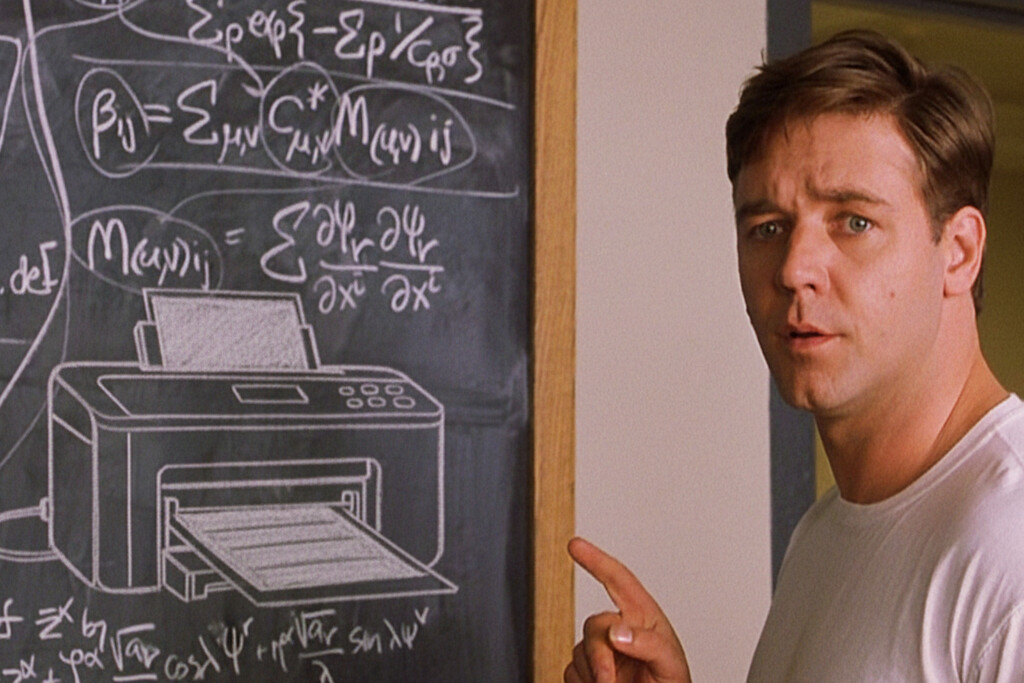

Imagen | Imagine Entertainment

En Xataka | HP lo apuesta todo a la IA en el trabajo. Su plan: reinventar hasta la impresión

-

La noticia

Las impresoras llevan 30 años siendo un producto terrible. La culpa es del equilibrio de Nash

fue publicada originalmente en

Xataka

por

Javier Pastor

.