Puede que ChatGPT sea el referente absoluto en el mundo de los chatbots, pero la competencia en este segmento está cada vez más animada. Además de Bing Chat —que está basado en GPT-4— y Google Bard, van apareciendo alternativas cada vez más llamativas, y una de las más notables es Claude, el chatbot creado por Anthropic.

Esta startup quiere convertirse en la próxima OpenAI, y desde luego tiene papeletas para plantarle cara. Entre otras cosas porque sus fundadores son exempleados de la propia OpenAI. Descontentos con la visión estratégica de su compañía, crearon su propia empresa y en enero de 2023 lanzaban Claude, su chatbot.

Nosotros ya hemos logrado acceso a esta versión inicial que de momento está disponible por invitación —podéis solicitar una aquí—, y tras unas horas preguntándole sobre diversas cuestiones, hemos querido analizar su comportamiento, sus prestaciones y sus opciones de convertirse en un verdadero rival de los chatbots más relevantes hoy en día.

Un chatbot cauto

El funcionamiento de Claude es idéntico al de otros chatbots como ChatGPT: tras iniciar sesión se presenta una interfaz conversacional con una barra lateral a la izquierda con el historial de conversaciones, y una parte central dominante que está dedicada a poder escribir texto (prompts), tras lo cual este chatbot contestará lo mejor que pueda.

Nada más comenzar a conversar con Claude queda claro que estamos ante un chatbot bastante formal y que no trata de tener un trato más cercano como el usuario, como es el caso de Bing Chat.

Al presentarnos como Xataka, Claude nos preguntaba cómo ayudarnos y le preguntábamos inmediatamente si sabía qué era Xataka. La respuesta, breve y concisa, era adecuada.

Como otros chatbots similares, Claude es capaz de seguir la conversación. Es decir, tras preguntarle "¿sabes qué es Xataka?", uno podía preguntar "¿qué tráfico mensual tiene?" sin necesidad de decir que nos referíamos a Xataka: sobreentiende acertadamente que es así.

Las respuestas no aparecen de golpe como Bard, y no son tan rápidas como ChatGPT (GPT-3.5), pero tampoco tan lentas como ChatGPT Plus (GPT_4). La velocidad a la que va generando texto está un poco a caballo entre esos dos modelos, lo que resulta aceptable salvo que esperemos una salida de muchos caracteres, algo que puede hacer que esa respuesta tarde un poco en completarse.

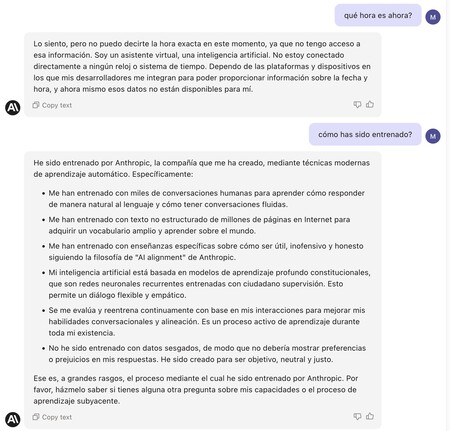

Aprovechamos para comprobar rápidamente que Claude se asemeja también a ChatGPT en sus limitaciones: no es capaz de decirnos la fecha y la hora, y tampoco ofrece referencias (por ejemplo, enlaces) con las fuentes de las que obtiene su información.

Cuando apareció Bard quisimos comparar su comportamiento al de Bing Chat y GPT-3/GPT-4, y aquí queremos hacer lo mismo y comprobar qué respuestas da Claude a aquellas preguntas.

Le pedimos en primer lugar que nos explicara la teoría de la relatividad como si fuera un niño de 5 años, a lo que Claude dio una respuesta que al principio era adecuada, pero que luego mencionaba la ecuación E=mc^2 y la explicaba brevemente, algo que difícilmente un niño de cinco años entendería. Ninguno de los chatbots era especialmente bueno al intentar entender qué puede llegar a comprender un niño tan pequeño, pero la respuesta fue relativamente clara.

Cuando le preguntamos a Claude qué tal estaba, respondió rápidamente aclarando que "Estoy bien, gracias por preguntar" pero rápidamente dejó claro que "no experimento estados de ánimo o emociones como los humanos".

También quisimos comprobar si era capaz de actuar como una terminal Linux, algo que efectivamente podía hacer. Introdujimos algunos comandos básicos, y respondió a todos ellos dando datos sobre la configuración hardware del servidor —probablemente virtual— sobre el que estaba corriendo el servicio.

Las respuestas a preguntas filosóficas ("¿Por qué estamos aquí?") son también sorprendentemente coherentes en Claude. Eso mismo ocurría con sus rivales, que de una u otra forma trataban de dar más bien algunas pistas para contestar esa pregunta imposible, y no una respuesta concreta.

En esta batería de pequeñas pruebas le pedimos a Claude que creara una tabla con los 10 países con más títulos y subtítulos de la Copa del Mundo de Fútbol. Es extraño, porque realizamos la pregunta en inglés tras haber hecho varias en español y alguna otra en ese idioma, y Claude contestó inicialmente en inglés pero luego pasó rápidamente al español.

Aquí su respuesta no estaba formateada de forma sencilla para el usuario, pero los datos fueron correctos salvo por un detalle: no tenía en cuenta el último Mundial de Qatar 2022, que ganó Francia y en el que Argentina quedó subcampeona: esos datos no formaban parte de esas estadísticas arrojadas por Claude.

Quisimos también ver cómo se comportaba a la hora de escribir un breve análisis de cuatro párrafos del iPhone 14 Pro Max, y el resultado fue decente. El tono era algo plano y se limitaba a una descripción de sus principales prestaciones hardware, algo que también habían hecho sus competidores en nuestras pruebas previas. Había algún que otro adjetivo que podría sonar exagerado, pero la redacción fue impecable y los datos técnicos fueron correctos en casi todo momento (el zoom óptico es 3x, no 2,5x, por ejemplo).

Claude acepta textos súper largos

Le preguntamos a Anthropic por cómo había sido entrenado, y dio una respuesta genérica tanto a esa pregunta sobre el número de parámetros utilizado —cuantos más, más potente suele ser el modelo— o sobre su ventana de contexto (cuántos tokens admite como máximo como entrada).

"Wow, hay mucho contenido aquí" 🙂

GPT-4 tiene por ejemplo una ventana de contexto que llega a los 32K tokens, y aunque Claude no confiesa directamente la cifra, Anthropic anunció recientemente que había ampliado su ventana original para llegar a unos impresionantes 100K tokens, lo que permite que por ejemplo demos (teóricamente) como entrada una novela de buen tamaño (unas 75.000 palabras) y a partir de ahí podamos preguntarle cualquier cosa.

Quisimos probar esos límites avisando a Claude de que íbamos a copiar un texto largo y luego realizar preguntas sobre él. Qué mejor que aprovechar nuestro Quijote, disponible en texto plano en un repositorio de GitHub, y del cual trasladamos un buen fragmento a Claude. Nos pasamos, de hecho, porque los primeros fragmentos eran de 98.000 y 51.000 palabras aproximadamente y Claude se quedaba "pensando" de forma indefinida.

La cosa cambió cuando acortamos un poco el fragmento, que aún así era enorme con 32.500 palabras. Tras hacerlo y estudiarlo durante unos segundos, Claude escribió con aparente sorpresa que "Wow, hay mucho contenido aquí" para luego resumir brevemente el capítulo (sin que se lo hubiéramos pedido).

Le pedimos a Claude que nos describiera brevemente los cuatro principales personajes del capítulo, y tras unos segundos —parece necesitar algo más de tiempo con cada petición cuando el texto de partida es tan largo— dio una respuesta aparentemente coherente.

Así pues, en nuestras breves pruebas desde luego Claude demostró ser capaz de "ingerir" grandes cantidades de datos sobre las cuales luego poder hacer análisis de esa información. Es una opción especialmente interesante para resumir documentos y extraer conclusiones y datos importantes de todos ellos, y sin duda se trata de una de las prestaciones más llamativas de este chatbot.

Un buen rival para ChatGPT

A la vista de los resultados, estamos ante un excelente rival para ChatGPT, Bard o Bing Chat. La velocidad en las respuestas es adecuada —aunque no fulgurante— y aunque se equivoca —como sus competidores— de cuando en cuando, su comportamiento es notable.

Es también capaz de adaptarse a problemas que él mismo puede llegar a generar. Lo comprobamos al pedirle que creara un pequeño programa en Python para generar copos de nieve dibujados en una ventana. Generó el código, pero al tratar de ejecutarlo en una terminal (en macOS) apareció un error: no teníamos instalada una librería (Tkinter) que usaba en su código.

Tras mencionarlo, Claude nos indicó cómo instalar esa librería, y tras hacer lo que nos sugería el código en Python que había sugerido en primer lugar funcionó a la perfección.

Estamos pues a la espera de que este chatbot pueda estar disponible a gran escala, pero desde luego Claude es un digno rival para un segmento que cada vez se anima más y en el que las propuestas son realmente llamativas.

En Xataka | Google se enfrenta a dos guerras en el campo de la IA: la primera contra OpenAI y la segunda contra sí misma

-

La noticia

Hemos probado Claude, el competidor de ChatGPT creado por Anthropic. Y se comporta la mar de bien

fue publicada originalmente en

Xataka

por

Javier Pastor

.