Una historia rocambolesca: compra una unidad SSD “nueva” y encuentra software que vale miles de euros

Reddit es una fuente inagotable de experiencias extrañas de las que los entusiastas de la tecnología podemos extraer algunas enseñanzas. La última historia sorprendente la ha compartido con la comunidad un usuario conocido como u / All-Seeing_Hands, y tiene una moraleja interesante que nos viene bien recordar. Todo comenzó cuando decidió comprar a través de internet una unidad SSD externa P1000 con interfaz USB 3.1 de la marca Gigastone.

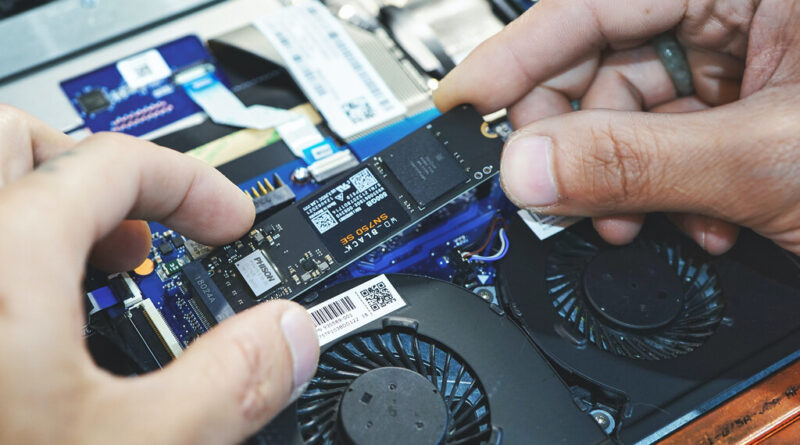

Cuando compramos un disco duro o una unidad de estado sólido en el mercado de segunda mano cabe la posibilidad de que su anterior propietario haya olvidado borrar correctamente todos sus datos (como veremos más adelante, hacerlo realmente bien no es un procedimiento trivial). Sin embargo, cuando adquirimos una unidad de almacenamiento nueva y precintada lo razonable es esperar que no haya sido utilizada, y, por tanto, que no contenga ningún tipo de información.

Esta historia nos recuerda que los distribuidores y las tiendas también cometen errores. Y algunos son graves. Cuando u / All-Seeing_Hands conectó la unidad externa a su PC se dio cuenta enseguida de que aunque tenía una capacidad de 1 TB solo podía utilizar 143 GB. El resto del espacio útil, casi 800 GB, estaba ocupado por un sinfín de carpetas que parecían contener aplicaciones poco habituales y bibliotecas. Esta unidad de Gigastone cuesta actualmente unos 110 euros, pero, sorprendentemente, su contenido vale miles de euros.

Han olvidado borrar los datos. Además, hacerlo bien no es trivial

Al parecer buena parte del software que contiene esta unidad externa son aplicaciones profesionales de creación musical, como Kontakt, Reaktor 6 o EZDrummer. Estas herramientas no son exageradamente caras, pero el precio conjunto de todas ellas es de varios miles de euros, eso sí, siempre y cuando se adquieran con una licencia legal. No sabemos con certeza cuál es la procedencia del software de esta unidad SSD, pero probablemente se trata de aplicaciones que han sido pirateadas por un usuario anterior del dispositivo.

No basta con recurrir al borrado simple que nos ofrecen los sistemas operativos; es esencial utilizar una herramienta de borrado seguro

Y es que la conclución más evidente a la que podemos llegar es que la unidad de estado sólido que ha comprado u / All-Seeing_Hands no es nueva. Probablemente fue adquirida y posteriormente devuelta a la tienda por otro usuario que, y de esto sí podemos estar seguros, olvidó borrar la información que había almacenado en el dispositivo. Después de la devolución la tienda se molestó en precintar de nuevo la unidad SSD, pero pasó por alto comprobar que no había datos en su interior. Y sí, los había. Y delatan que el dispositivo ya había sido utilizado.

Esta historia podría quedar como una simple anécdota, pero merece la pena darle visibilidad porque sirve para recordarnos lo importante que es cerciorarse de que cuando vendemos una unidad de almacenamiento o un PC en el mercado de segunda mano hemos eliminado correctamente nuestra información. Además, no basta en absoluto con recurrir al borrado simple que nos ofrecen los sistemas operativos; es esencial utilizar una herramienta de borrado seguro.

Si no lo hacemos corremos el riesgo de que la persona que utilice nuestra unidad de almacenamiento pueda recuperar toda la información que hemos eliminado incorrectamente. Las herramientas de borrado seguro suelen efectuar escrituras iterativas con el propósito de sobreescribir varias veces los archivos que queremos eliminar definitivamente. Eraser es una de las que más nos gusta, pero, como nos recuerdan nuestros compañeros de Genbeta, hay muchas herramientas de borrado definitivo que nos pueden ayudar a salvaguardar nuestra información privada. Y algunas de ellas son gratuitas.

Imagen de portada: Phiraphon Srithakae

Más información: Reddit

-

La noticia

Una historia rocambolesca: compra una unidad SSD "nueva" y encuentra software que vale miles de euros

fue publicada originalmente en

Xataka

por

Juan Carlos López

.