¿Quién está ganando la carrera de la IA? A estas alturas deberíamos tenerlo más o menos claro. Lo teníamos cuando Microsoft e Intel se perfilaron como los dominadores del mundo del PC o cuando Apple y Google triunfaron con sus smartphones. Pero con la IA ocurre algo curioso: las cosas están muy igualadas.

De, hecho, demasiado.

Desde luego en el ámbito de la popularidad OpenAI es la más destacada con ChatGPT. Hace poco la empresa presumía de estar rozando los 700 millones de usuarios semanales activos, una cifra realmente notable que deja atrás a sus competidoras. Sin embargo, esa métrica no es de momento definitiva, sobre todo cuando tenemos una gran incógnita que dilucidar: ¿Cuál es el mejor modelo de IA?

Es imposible saber a día de hoy cuál es el mejor modelo de IA

Nadie puede dar una respuesta clara a esa pregunta. Ni las empresas, que sacan pecho continuamente con sus nuevas versiones, ni los benchmarks, que se han convertido en una herramienta útil pero imperfecta a la hora de evaluar la calidad de esos modelos.

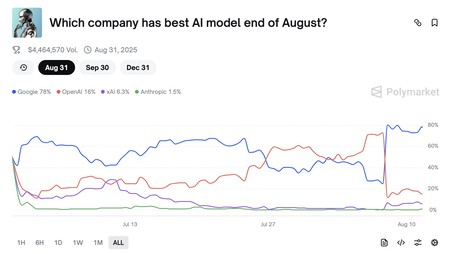

En Polymarket la gente creía que el mejor modelo de IA a finales de agosto iba a ser OpenAI. Tras salir GPT-5, la percepción cambió.

Que la respuesta a esa pregunta es difícil lo demuestra Polymarket, esta singular plataforma de predicción en la que los usuarios apuestan por un resultado y lo hacen además pagando por votar a una u otra conclusión. A la pregunta de "¿Qué compañía tiene el mejor modelo de IA a finales de agosto?

Todo parecía sonreirle a OpenAI, pero tras el lanzamiento de GPT-5, el batacazo: ahora el claro favorito es Gemini, el modelo de Google, con OpenAI desplomándose al 16% de los votos y aún más atrás Grok (xAI) con un 6,3% de votos y Claude (Anthropic) con un bajísimo (en mi opinión) 1,5%.

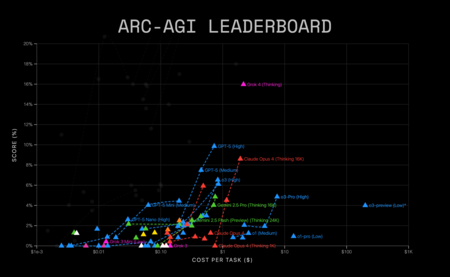

No es que Polymarket sea un indicador especialmente fiable de esto (ni de nada), pero deja claro que la percepción pública de estos modelos puede ser muy distinta de su comportamiento real en cosas como su número de usuarios —aquí OpenAI tumba a sus competidores— o su rendimiento en pruebas como ARC-AGI 2 (donde Grok 4 gana a todos, incluido GPT-5).

En el benchmark de pensamiento abstracto ARC-AGI 2, Grok 4 está muy por encima de sus competidores. Incluido GPT-5, que supera por muy poco a Claude Opus 4. Fuente: ARC-AGI.

Y eso nos deja aún más claro cuáles son los dos grandes motivos por los que es un verdadero problema saber qué modelo de IA está ganando esta carrera. El primero, que esas pruebas son a menudo muy específicas y concretas, y se centran en evaluar aspectos como la capacidad de programar o resolver problemas matemáticos de estos modelos.

Y el segundo, que los modelos no paran de mejorar y de ir superando lo que sus rivales habían logrado unos días, semanas o meses antes. No paramos de ver cómo nuevas versiones de los modelos son (lógicamente) algo mejores programando, generando texto o imágenes o resolviendo cierto tipo de problemas, pero no hay una forma consensuada ni definitiva de decir "este modelo es mejor".

Como hemos visto, cada usuario tiene además su propia percepción personal (hola, Polymarket) al usarlos. Unos prefieren Claude para programar, otros ChatGPT para preguntas genéricas, otros Gemini para conversar sobre temas diversos y para aprender, por ejemplo. Y ninguno parece ser el modelo definitivo "para todo".

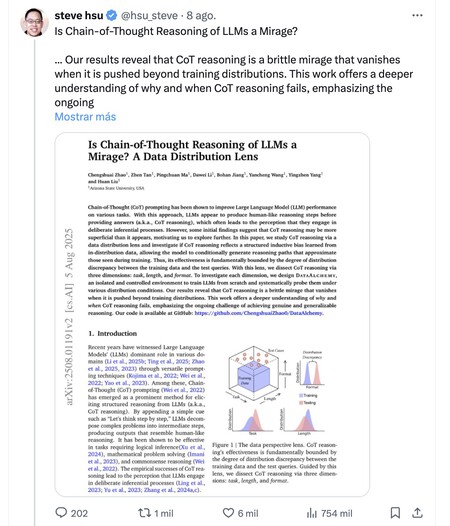

En un reciente estudio científico, el investigador Steve Hsu llegaba a la conclusión de que el camino que siguen los modelos de IA generativa actuales no llevará a la AGI. Ni ahora, ni nunca.

Eso nos lleva a una reflexión: la de que esa inteligencia artificial general (AGI) está lejos de llegar. Esos sistemas, que se supone nos iban a superar en todas las áreas, no están ni remotamente cerca de hacerlo, y siguen cometiendo errores aun cuando por ejemplo GPT-5 parece haber mitigado sensiblemente el problema de las alucinaciones. Analistas como Gary Marcus nos recordaban estos días que llevan cerca de 30 años diciendo lo mismo: que con este tipo de técnicas de escalado no vamos a llegar a una AGI y que el camino tiene que ser otro.

Y eso nos deja algunas ideas interesantes.

David Sacks —cofundador de PayPal, fundador de Yammer, inversor— analizaba la situación de este segmento y planteaba conclusiones llamativas. Las cinco principales empresas que desarrollan modelos fundacionales —OpenAI, Google, Meta, Anthropic o xAI— siguen sin dominar el mercado, pero eso es (o puede ser) buena noticia.

Y lo es porque no hay ni un monopolio ni un duopolio de la IA. Lo que hay es una competencia feroz no solo entre estas cinco empresas norteamericanas, sino entre ellas y todas sus competidoras chinas, a las que se suman un montón de startups que no tienen recursos para trabajar en modelos fundacionales —carísimos— y en su lugar tratan de resolver otra gran pregunta: cuál es la killer app de la IA.

Ahí es donde hay grandes oportunidades para estas startups, que pueden resolver casos de éxito en los que la IA realmente pueda ser una disrupción para una industria. Es por ejemplo lo que han hecho empresas emergentes como Cursor o Windsurf, que han apostado por el auge del vibe coding y están captando mucho interés entre el segmento de los desarrolladores.

De hecho, cada vez vemos cómo incluso las grandes de la IA presumen de que sus nuevos modelos programan especialmente bien o quizás están más orientadas que nunca a resolver problemas matemáticos. GPT-5 precisamente esgrime esos dos argumentos para declararse mejor que la competencia, y aunque algunos benchmarks le dan la razón, la percepción de los usuarios determinará si cumplen con las expectativas o no.

Pero también está ese gran debate entre los modelos propietarios (como GPT-5) y los modelos Open Source. Como dice Sacks, el hecho de que los modelos Open Source puedan ofrecer un 80-90% de la capacidad con un coste del 10-20% de los modelos fundacionales es sensacional para ciertos usuarios.

En concreto, para los que priorizan personalización, control y ahorro de costes sobre el uso de modelos fundacionales. China va a por todas con esa filosofía, aunque curiosamente fue Meta la que enseñó el camino —que ahora parece haber descartado— y OpenAI acaba de cogerlo como plan B.

Una ganadora insospechada de la carrera de la IA: Apple

Han pasado casi tres años desde que OpenAI lanzara ChatGPT, y en todo este tiempo hemos asistido al auge frenético de la IA. Las promesas y las expectativas lo han inundado todo, y aunque estos modelos han demostrado ser muy útiles y ciertamente sorprendentes en algunos escenarios, la revolución real no está ahí.

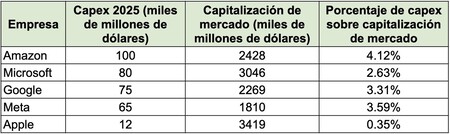

Los gastos de capital proyectados para 2025 por parte de las Big Tech son extraordinarios excepto en un caso: Apple, que parece no confiar demasiado en la IA. Al menos, de momento.

Pero mientras se produce, casi todas las grandes empresas tecnológicas se han gastado cantidades irreverentes de dinero para desarrollar sus modelos de IA o infraestructura con la que soportar la teórica demanda de un mundo ávido por conversar con sus chatbots.

Y sin embargo, todas ellas están perdiendo dinero a lo grande. Las inversiones siguen sin ser rentables y no está claro cuándo lo serán (si es que lo son alguna vez), pero hay una Big Tech que se ha mantenido en un sorprendente segundo plano: Apple.

Puede que ellos mismos fueran los que decidieron perder el tren y cogerlo si por fin tenía sentido hacerlo. Puede que lo perdieran por negligencia o por un error de cálculo. Sea como fuere, Apple no trabaja en grandes modelos fundacionales ni tampoco en crear una red gigantesca de centros de datos.

Así que en lugar de apostarlo todo a la IA inmediatamente, en Apple se mantienen en un discretísimo —y decepcionante— segundo plano, con una implementación muy pobre de opciones de IA en sus sistemas operativos y con un claro fiasco y retraso en el despliegue de la nueva versión de Siri.

En lugar de eso, Apple parece confiar en acabar creando la killer app de la IA. Esa que pueda demostrar que esta tecnología era una commodity y lo que importa no era tener el mejor modelo fundacional, sino en saber aplicarlo y aprovecharlo.

El enfoque de la compañía de Cupertino parece claro: apuestan una vez más por la privacidad y por poder ejecutar esos modelos en local. Eso, conjugado con la obsesión de Tim Cook por las gafas de realidad aumentada podría acabar dando resultado —unas Meta RayBan con mucha IA, pero de Apple—, pero hoy por hoy todo son cábalas y especulación.

Si esa es realmente la apuesta de Apple, lo va a tener complicado. Sobre todo porque no va a estar sola en ese ámbito. Google está trabajando en sus propias gafas de realidad aumentada con IA, y desde luego Meta lleva tiempo en esa batalla y es referente absoluto (sin olvidar la alianza OpenAI-Jony Ive). Las empresas tecnológicas chinas tampoco van a dejar escapar su oportunidad, pero si hay una empresa que sabe combinarlo software y hardware de forma notable, esa es Apple.

Todo está por ver, pero lo que está claro es que hoy por hoy ninguna empresa está ganando la carrera de la IA. Y ahí está lo emocionante.

Imagen | Xataka con ChatGPT

En Xataka | ¿Es Tim Cook el Ballmer de Apple y es Nadella el Jobs de Microsoft?

-

La noticia

Si la pregunta es cuál de las grandes tecnológicas está ganando la carrera de la IA, la respuesta es: ninguna

fue publicada originalmente en

Xataka

por

Javier Pastor

.