Solo se producen 20 kg de tritio al año en el mundo: así aspira la fusión nuclear a conseguir todo el que necesita

El tritio que está presente en la naturaleza es muy escaso. Escasísimo. Este isótopo radiactivo del hidrógeno se produce de forma natural en las capas superiores de la atmósfera debido a la interacción de los rayos cósmicos y los núcleos de los gases atmosféricos, pero su producción es muy modesta. De hecho, en la atmósfera de la Tierra solo se producen anualmente unos pocos kilogramos. Tan pocos, de hecho, que los científicos estiman que podemos contarlos con nuestros dedos.

Curiosamente no todo el tritio que está disponible en nuestro planeta tiene un origen natural. Las pruebas nucleares atmosféricas que tuvieron lugar entre el final de la Segunda Guerra Mundial y los años 80 han arrojado unas pocas decenas de kilogramos de este isótopo a los océanos, y, además, los reactores nucleares de tipo CANDU, que son dispositivos de agua pesada sometida a presión desarrollados en Canadá, también lo producen. Cada reactor de 600 MW genera anualmente unos 100 g de tritio, por lo que su producción global anual es de unos 20 kg.

ITER, el reactor experimental de fusión nuclear que un consorcio internacional liderado por la Unión Europea está construyendo en la localidad francesa de Cadarache, utilizará como combustible dos isótopos del hidrógeno: deuterio y tritio. Como acabamos de ver, el tritio es muy escaso, pero el que está acumulado actualmente en todo el planeta es suficiente para garantizar que este reactor experimental de energía de fusión tendrá el que necesita durante toda su vida operativa, que se prolongará aproximadamente durante quince años.

El problema es que después de ITER llegará DEMO, que será el reactor de fusión nuclear de demostración que aspira a poner sobre la mesa la validez de esta tecnología para producir grandes cantidades de electricidad. Y después de DEMO, si todo sale como han previsto los ingenieros de ITER, llegarán las primeras centrales eléctricas comerciales de energía de fusión. Cada uno de sus reactores necesitará anualmente entre 100 y 200 kg de tritio, así que es evidente que las cuentas no salen. Los reactores CANDU no pueden generar la gran cantidad de tritio que necesitarán las máquinas de fusión, pero, afortunadamente, este dilema tiene solución. Una muy ingeniosa.

ITER probará una estrategia innovadora para producir grandes cantidades de tritio

El propósito de los científicos que trabajan en la fusión nuclear mediante confinamiento magnético, que es la estrategia utilizada actualmente por los reactores experimentales JET, en Oxford (Inglaterra), y JT-60SA, en Naka (Japón), es que los futuros reactores de energía de fusión sean capaces de generar por sí mismos todo el tritio que necesitan. Que sean capaces de autoabastecerse. Este plan propone que el aporte externo de tritio sea mínimo y se ciña a momentos muy concretos de la vida operativa del reactor de fusión nuclear. Suena bien, pero lo más interesante es saber cómo van a hacerlo.

Uno de los subproductos resultantes de la fusión es un neutrón que sale despedido con una energía de unos 14 MeV

Y, sobre el papel, lo que van a hacer es sencillo: van a colocar litio en el manto que recubre el interior de la cámara de vacío del reactor de fusión. Uno de los subproductos resultantes de la fusión de un núcleo de deuterio y otro de tritio es un neutrón que sale despedido con una energía de unos 14 MeV. Cuando una de estas partículas incide sobre uno de los átomos de litio alojados en el manto de la cámara altera su estructura, produciendo de esta forma un átomo de helio, que es un elemento químico inocuo, y un átomo de tritio. Aquí lo tenemos. Esto es justo lo que necesitan los reactores de energía de fusión. Sobre el papel parece una idea simple, pero llevarla a la práctica no es nada sencillo.

Los desafíos que plantea la puesta a punto de las soluciones tecnológicas que son necesarias para implementar el autoabastecimiento de tritio son enormes. Por un lado es imprescindible que la tasa que relaciona los neutrones de alta energía producidos en la fusión y los átomos de tritio generados en las paredes de la cámara de vacío sea la idónea. Además, es necesario resolver el transporte del tritio desde el lugar en el que se genera hasta el lugar en el que va a ser consumido, y no es algo en absoluto trivial porque es un gas que se dispersa fácilmente, especialmente a altas temperaturas. Este procedimiento plantea otros retos, pero estos dos son críticos. Crucemos los dedos para que la regeneración del tritio en ITER salga bien.

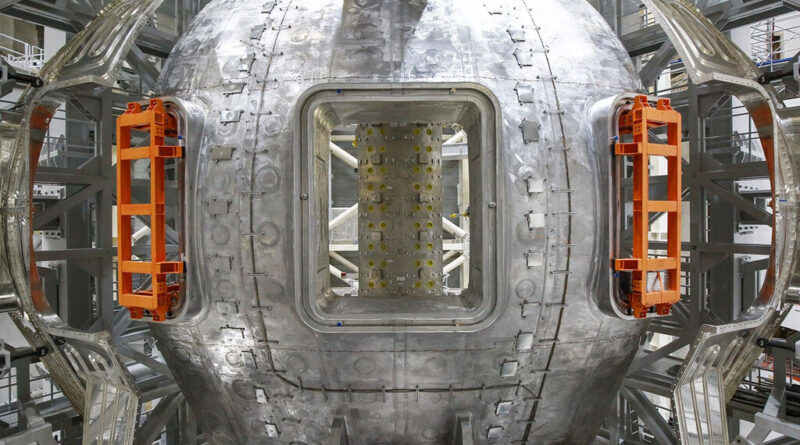

Imagen de portada: ITER

Más información: Fusion for Energy | ITER

-

La noticia

Solo se producen 20 kg de tritio al año en el mundo: así aspira la fusión nuclear a conseguir todo el que necesita

fue publicada originalmente en

Xataka

por

Juan Carlos López

.